Ethische und Soziale Implikationen von KI-Agenten – Der Einsatz von KI-basierten Konversationsagenten und digitalen Assistenten bringt viele Vorteile – aber auch einige Fragen mit sich.

Worüber machen sich Menschen Gedanken? 🧠

- Datenschutz und Sicherheit: Wie sicher sind die Daten, die KI sammelt und verarbeitet?

- Arbeitsplätze: Könnte Automatisierung in manchen Bereichen Arbeitsplätze ersetzen?

- Fairness: Sind die Antworten der KI neutral, oder gibt es ungewollte Vorurteile in den Ergebnissen?

- Menschliche Interaktion: Ersetzen wir echte Gespräche durch Konversationen mit Maschinen?

- Verantwortung: Wer trägt die Verantwortung für Fehler oder Entscheidungen der KI?

Weitere Überlegungen: 💭

- Transparenz: Wissen die Nutzer immer, ob sie mit einer KI sprechen?

- Abhängigkeit: Besteht die Gefahr, dass Menschen sich zu sehr auf KI verlassen oder sie als Begleitung im Alltag nutzen?

- Psychische Gesundheit: Wie beeinflusst der Einsatz von KI unser Wohlbefinden und unser soziales Miteinander?

KI kann viel Gutes bewirken – aber es lohnt sich, diese Aspekte im Blick zu behalten, um Technologie verantwortungsvoll zu gestalten.

Erklärbare KI (XAI): Verstehen, wie Künstliche Intelligenz Entscheidungen trifft ⚙️

Sind die Antworten des KI-Konversationsagenten erklärbar und interpretierbar? 🤔

Künstliche Intelligenz kann unglaublich komplexe mathematische Muster in riesigen Datenmengen erkennen – oft so kompliziert, dass sie das menschliche Verständnis übersteigen (Blackman und Ammanath 2022). Das Problem: Wir verstehen zwar, welche Daten in ein KI-System fließen und welche Ergebnisse es liefert, aber die Prozesse dazwischen bleiben häufig undurchsichtig. Diese „Black Box“ macht es schwer, Fragen zur Zuverlässigkeit und Funktionsweise der KI zu beantworten. Das kann problematisch sein, vor allem wenn es um Entscheidungen mit großen Auswirkungen geht (ibid.).

Studien zeigen, dass fehlende Transparenz die Glaubwürdigkeit von KI-Systemen beeinträchtigen kann. Das wiederum führt zu weniger Vertrauen und einer schlechteren Nutzererfahrung (Weitz et al. 2020; Linegang et al. 2006; Stubbs, Hinds und Wettergreen 2007). Aus diesem Grund fordern viele Experten „Explainable AI“ (XAI) – also erklärbare künstliche Intelligenz. XAI sorgt dafür, dass Entscheidungen und Vorhersagen der KI verständlich und nachvollziehbar werden (Blackman und Ammanath 2022).

Was bedeutet Erklärbarkeit in der KI? ❓

Erklärbarkeit bedeutet, dass wir nachvollziehen können, warum eine KI bestimmte Entscheidungen trifft. Die Funktionsweise der Algorithmen wird so aufbereitet, dass Menschen verstehen, welche Faktoren zu einem bestimmten Ergebnis geführt haben (Samek, Wiegand und Müller 2017; Doshi-Velez und Kim 2017)

Technisch gesehen geht es darum, kritische Elemente innerhalb des KI-Modells zu identifizieren – also die Teile, die den größten Einfluss auf eine Vorhersage oder die Genauigkeit des Modells haben. Ziel ist es nicht, die KI direkt wie ein Mensch zu erklären (Holzinger und Müller 2021), sondern zu zeigen, welche Daten und Prozesse die Entscheidungen beeinflussen.

Warum ist Erklärbarkeit wichtig? ✅

Verschiedene Gruppen – von Nutzern bis hin zu Regulierungsbehörden – möchten unterschiedliche Einblicke in die Arbeitsweise von KI-Systemen erhalten. Die richtige Aufbereitung der Informationen hilft dabei, Entscheidungen zu verstehen und zu bewerten.

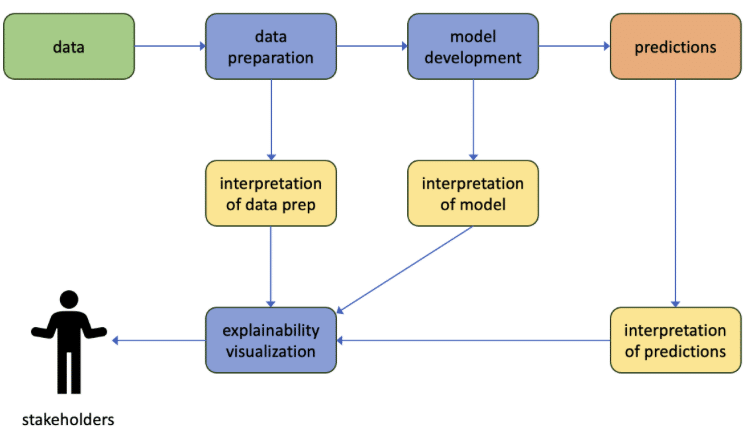

Erklärbarkeit endet jedoch nicht bei den Ergebnissen der KI. Auch die Auswahl und Vorbereitung der Daten, die ein Modell trainieren, müssen transparent gemacht werden. Die Qualität der Daten beeinflusst maßgeblich, wie zuverlässig und fair eine KI arbeitet (McDermid et al. 2021). In Abbildung 1 wird das nochmal visuell deutlich gemacht.

Ein Ziel von „Explainable AI“ (XAI) ist es, neue Methoden zu entwickeln, die komplexe und oft undurchsichtige KI-Modelle verständlicher machen. Diese Erklärungs-Algorithmen sollen Nutzern helfen, die Entscheidungen der KI besser zu verstehen und ihr mehr zu vertrauen (Chen et al. 2014; Lane et al. 2005; Mercado et al. 2015).

Wie funktioniert das?

Ein Ansatz sind Visualisierungen, wie zum Beispiel sogenannte Saliency Maps. Sie zeigen, welche Eingaben besonders wichtig für die Entscheidung der KI waren (Weitz et al. 2020).

Erklärungen wie von Mensch zu Mensch

Ein interessanter Vorschlag von Graaf und Malle (2017) ist, dass KI-Erklärungen so aufgebaut sein sollten, wie Menschen sich gegenseitig Dinge erklären. Wenn KI-Systeme ihre Entscheidungen ähnlich wie Menschen verständlich machen, könnte das Vertrauen und Verständnis der Nutzer steigen (Weitz et al. 2020).

Wo stehen wir heute?

Aktuelle XAI-Methoden können zwar komplexe KI-Modelle entschlüsseln, bieten aber nicht immer die Tiefe an Erklärungen, die Nutzer sich wünschen. Ein spannender Weg für die Zukunft ist es, diese Erklärungen in Interaktionen einzubetten, die an menschliches Verhalten erinnern.

Menschliches Verhalten als Vorbild

Wenn KI-Systeme menschliches Verhalten nachahmen – etwa durch Sprache, Körpersprache oder Lippenbewegungen – neigen Nutzer dazu, den Erklärungen mehr zu vertrauen (Weitz et al. 2020). Diese „menschlichere“ KI-Interaktion könnte die Akzeptanz und das Vertrauen in KI-Systeme weiter stärken.

Erklärbare KI schafft Vertrauen – und das ist entscheidend für den erfolgreichen Einsatz dieser Technologie.

Was passiert mit meinen Daten – die Bedenken bezüglich Privatsphäre. 🔒

Künstliche Intelligenz (KI) steht immer mehr im Fokus von Regulierungsbehörden, wenn es um Ethik, Datenschutz und Vertrauen geht. Dies liegt daran, dass KI-Technologien viele Bereiche verändern können – von der Arbeitswelt bis hin zu gesellschaftlichen Normen (Følstad et al. 2021).

Was wird getan, um KI verantwortungsvoller zu gestalten?

Es gibt bereits Initiativen wie die Ethik-Leitlinien der Europäischen Kommission für vertrauenswürdige KI oder Microsofts FATE-Programm. Diese Programme setzen sich dafür ein, Vorurteile in KI-Systemen zu reduzieren und Fairness zu gewährleisten (Ntoutsi et al. 2020).

In Europa regelt die Datenschutz-Grundverordnung (DSGVO) den Umgang mit persönlichen Daten. Dies hat zur Folge, dass viele Richtlinien für KI-Systeme auf Datenschutz, Ethik und technische Sicherheit ausgelegt sind (Europäische Kommission 2019). Die Kommission empfiehlt, dass KI von Menschen überwacht wird, fair und diskriminierungsfrei agiert und die Privatsphäre respektiert (Følstad et al. 2021).

Datenschutz im Alltag

Wenn Verbraucher an Datenschutz denken, geht es oft darum, wie sehr sie sich davor fürchten, dass ihre persönlichen Daten ohne Zustimmung weitergegeben werden (Baek und Morimoto 2012).

Zwei wichtige Datenschutzfragen

- Identifizierbarkeit: Auch wenn offensichtliche Daten wie Name oder Kreditkartennummer leicht zu erkennen sind, können auch unscheinbare Informationen wie Alter, Geschlecht und Postleitzahl zur Identifikation führen.

- Datenempfindlichkeit: Manche Daten, etwa politische Ansichten oder der Aufenthaltsort, sind sensibler als andere.

Mit KI steigt sowohl die Identifizierbarkeit als auch die Menge an sensiblen Daten. Dies kann Bedenken verstärken – besonders, wenn KI genutzt wird, um Menschen in Gruppen einzuteilen oder zu klassifizieren (Guha et al. 2021).

Wie beeinflusst Datenschutz das Nutzerverhalten?

Studien zeigen, dass Menschen genau abwägen, ob sie persönliche Daten preisgeben – abhängig vom Nutzen, den sie sich davon versprechen (Dinev und Hart 2006). In Bereichen wie Mental Health-Chatbots entscheidet oft das Verhältnis zwischen Datenschutzrisiken und dem erwarteten Mehrwert (Viswanath et al. 2020).

Interessant ist, dass Nutzer weniger Datenschutzbedenken haben, wenn KI-Systeme menschlicher wirken – etwa durch Sprache oder Körpersprache. Menschliche Konversationsagenten werden als vertrauenswürdiger empfunden, was die Bereitschaft zur Dateneingabe erhöht (Ischen et al. 2020).

Vorurteile in KI-gestützten Chatbots – Ein echtes Problem?

KI-Chatbots können manchmal unfaire oder diskriminierende Antworten geben. Das passiert, weil die KI aus Daten lernt, die bereits gesellschaftliche Vorurteile enthalten (Ntoutsi et al. 2020). Diese Biases können sich in verschiedenen Formen zeigen – etwa in Bezug auf Geschlecht, Herkunft, Kultur oder politische Ansichten (Caliskan et al. 2017).

Beispiele aus der Praxis:

- Ein KI-System zur Vorhersage von Rückfallrisiken (COMPAS) bewertete schwarze Angeklagte häufiger als „hochrisikoreich“, obwohl ihr tatsächliches Rückfallrisiko niedriger war – während weiße Angeklagte als weniger riskant eingestuft wurden (Angwin et al. 2016).

- Ein Werbetool von Google zeigte Männern häufiger Anzeigen für hochbezahlte Jobs als Frauen (Datta et al. 2015).

Solche Vorfälle haben das öffentliche Bewusstsein für die gesellschaftlichen Auswirkungen von KI geschärft (Ntoutsi et al. 2020).

Warum passiert das?

KI-Systeme lernen aus vergangenen Daten. Selbst wenn Merkmale wie Geschlecht oder Hautfarbe nicht direkt verwendet werden, kann die KI sie aus anderen Informationen ableiten. Dies könnte dazu führen, dass bestimmte Gruppen benachteiligt werden – sei es durch höhere Preise oder andere Formen von Ungleichbehandlung (Guha et al. 2021).

Was bedeutet das für Unternehmen?

Vorurteile in KI-Systemen könnten nicht nur zu einem Imageschaden führen, sondern auch Kunden verlieren oder Geschäftschancen verpassen. Besonders in Bereichen, in denen KI direkt mit Kunden interagiert (z.B. Chatbots im Einzelhandel), könnten diese Bedenken die Einführung solcher Systeme verlangsamen.

Bias bei der Entwicklung von Chatbots

Vorurteile können sich nicht nur in den Antworten, sondern auch im Design und Verhalten von Chatbots zeigen. Manche Chatbots bevorzugen zum Beispiel bestimmte kulturelle Gruppen oder spiegeln unbewusst die Werte der Entwickler wider.

Wie lässt sich das verhindern? ❌

Um Vorurteile zu reduzieren, sollten Entwickler:

- Vielfältige Daten aus unterschiedlichen Gruppen nutzen,

- Chatbots regelmäßig testen und anpassen,

- und sicherstellen, dass die KI in verschiedenen kulturellen Kontexten fair arbeitet (Luxton 2020).

KI-basierte Konversationsagenten können viel bewirken – aber nur, wenn sie gerecht und transparent gestaltet sind.

KI Chatbots – Bequeme Entscheidung oder Illusion der Wahlfreiheit? 🤷🏼

KI-gestützte Chatbots und smarte Technologien werden zunehmend in Geschäften eingesetzt, um Kunden bei Entscheidungen zu unterstützen. Doch was bedeutet das für unsere Wahlfreiheit?

In der heutigen Welt treffen immer mehr smarte Technologien Entscheidungen für uns – oft mit unerwarteten Folgen für Einzelne und die Gesellschaft. Diese „erweiterte Entscheidungsfindung“ kann die Freiheit der Wahl untergraben. Der Preis dafür ist unsere Bequemlichkeit (Buder, Pauwels und Daikoku 2021).

Wie beeinflusst KI unsere Entscheidungen?

Viele KI-Modelle funktionieren wie eine Blackbox – wir wissen nicht genau, wie und warum Entscheidungen getroffen werden. Das bedeutet: Wenn Kunden nicht verstehen, wie ein Chatbot eine Produktempfehlung ausspricht, wissen sie auch nicht, ob es wirklich die beste Wahl für sie war.

Intelligente Algorithmen analysieren riesige Mengen an Daten, erkennen Muster und machen Vorschläge. In vielen Bereichen ist das hilfreich – zum Beispiel bei Ärzten, Führungskräften oder Piloten, die in kritischen Situationen schnelle Entscheidungen treffen müssen. Im Einzelhandel geht es zwar „nur“ um Produktempfehlungen, aber auch hier könnte die falsche Entscheidung dazu führen, dass Kunden etwas Unpassendes oder Teureres kaufen.

Bequemlichkeit vs. Manipulation

KI reduziert die Informationsflut, filtert relevante Produkte heraus und macht unser Leben einfacher. Wir müssen weniger Zeit mit Suchen verbringen und können uns auf angenehmere Dinge konzentrieren. Doch es gibt auch eine Kehrseite:

- Unternehmen könnten KI nutzen, um ihre Produkte gezielt zu bevorzugen – auch wenn sie nicht die beste Wahl für Kunden sind.

- Händler könnten Produkte empfehlen, die ihnen den höchsten Gewinn bringen (Buder et al. 2021).

Das Problem: Wir vertrauen oft auf diese Technologien und vergessen, dass wir möglicherweise nur einen Ausschnitt der Realität sehen – angepasst an die Interessen der Unternehmen. So kann die Freiheit der Wahl zur Illusion werden.

Das Ziel: Fairer und transparenter KI-Einsatz 🙏🏼

Ein Ziel zukünftiger Entwicklungen ist es, Chatbots zu schaffen, die auf die Bedürfnisse der Kunden eingehen und faire Entscheidungen treffen. Doch es besteht immer das Risiko, dass Händler die Technologie später zu ihrem Vorteil ändern – auf Kosten der Kunden.

Der Einsatz von KI kann viel bewirken – solange Transparenz und Fairness im Mittelpunkt stehen.

🔎 Neugierig geworden?

Dann schau gerne auf unserem Blog vorbei – dort findest du noch mehr spannende Beiträge rund um KI.

📬 Noch mehr Updates gefällig?

Auf LinkedIn teilen wir regelmäßig Insights, Tools und News zu aktuellen Entwicklungen. Folge uns dort oder wirf einen Blick in unseren Newsletter – wir freuen uns auf dich!